ما در مورد هوش مصنوعی و یادگیری ماشینی و کاربرد آنها در بحث امنیت سایبری حرفهای زیادی شنیدهایم. استفاده از این فناوریها باعث شده تا تشخیص و پاسخ به رفتارهای مخرب و مشکوک سرعت و دقت بیشتری بگیرد. اما مانند بسیاری از فناوریها، هوش مصنوعی هم میتواند در کنار تمام فوایدی که دارد، در مسیر بد و کارهای نادرست نیز به کار گرفته شود. یکی از کاربردهای هوش مصنوعی که در چند سال اخیر مورد توجه ویژه قرار گرفته و جنجال به راه انداخته است، امکان ایجاد دیپ فیک (Deepfake) یا جعل عمیق از محتوای صوتی و تصویری با استفاده از «شبکههای مولد متخاصم» یا GAN ها است. در این پست نگاهی به فناوری دیپ فیک میاندازیم و سعی میکنم به این پرسش پاسخ دهیم که آیا جای نگرانی در مورد این تکنولوژی جدید وجود دارد یا نه؟ با ما در دیجی رو همراه باشید.

دیپ فیک چیست؟

ایده تغییر چهره به هیچ عنوان ایده جدیدی نیست و از روزگاران گذشته قوه تخیل انسانها را تحریک کرده است. اگر اهل سینما و تماشای فیلم باشید، حتماً با موارد متعددی از امکان تغییر چهره در فیلمهای علمی تخیلی و یا حتی ژانرهای دیگر برخورد کردهاید. از بارزترین نمونههای چنین فیلمهایی میتوان به فیلم «تغییر چهره» (Face/Off) با بازی نیکلاس کیج و جان تراولتا اشاره کرد. با اینکه کارهایی از قبیل تغییر چهره هنوز هم ایدههایی تخیلی محسوب میشوند، اما با پیشرفت فناوریهای دیجیتال انجام چنین کارهایی حداقل در دنیای مجازی امکانپذیر شده است. دیپ فیک نام یک فناوری جدید و نوظهور در این عرصه است، که باعث شده بعد از گذشت سالها فیلم «تغییر چهره» کمی باورپذیرتر جلوه کند!

دیپ فیک در واقع به فرایندی اطلاق می شود که در آن با استفاده از یادگیری ماشین اقدام به تولید نوعی محتوای رسانهای جعلی می شود (به طور معمول یک فیلم باصدا یا بیصدا). در این محتوای رسانهای جعلی، چنان به نظر می رسد که شخص یا اشخاصی مطالبی را بیان می کنند، اما این در حالی است که در واقع آنها هیچ وقت چنین سخنانی نگفتهاند! به عنوان نمونه میتوانید ویدیوی زیر را که در آن جیم میسکیمن، کمدین معروف آمریکایی، به جای چندین سلبریتی معروف صحبت میکند تماشا کنید.

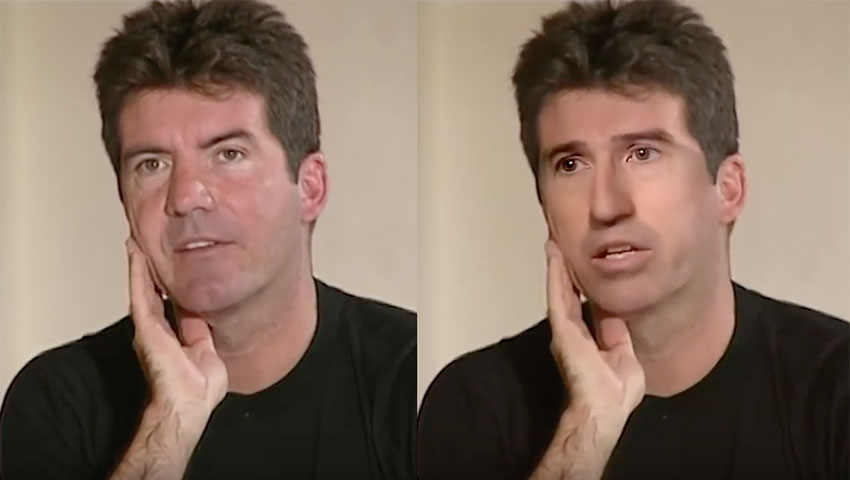

در حقیقت، دیپ فیک پا را از تکنیک های قدیمی و سنتی ویرایش محتوای صوتی و تصویری فراتر گذاشته و از پردازش رایانهای و یادگیری ماشین برای تولید محتوای ویدیویی و صوتی واقع گرایانه استفاده میکند تا به این وسیله بتواند اتفاقاتی را به تصویر بکشد که هرگز رخ ندادهاند. در حال حاضر، این فناوری کمابیش محدود به “تعویض چهره” است؛ به این ترتیب که سر یک فرد بر روی بدن فرد دیگر قرار گرفته و حرکات لب او نیز با صدای شخص هماهنگ میشود. با این وجود، نتیجه کار می تواند بسیار خیره کننده باشد.

اما جنجالها در مورد دیپ فیک از سال 2017 آغاز شد. زمانی که شخصی با نام کاربری deepfakes در وب سایت ردیت (Reddit)، اقدام به ساخت دیپ فیک از سلبریتیهای مشهور و قرار دادن چهره آنها به جای چهره بازیگران فیلمهای مستهجن کرد. پس از آن نیز افراد دیگری اقدام به ارسال پستهای مشابه کردند تا اینکه مدیران ردیت دیپ فیک را ممنوع کردند و صفحات مذکور را نیز به کل حذف نمودند.

البته این تنها آغاز ماجرا بود. هنگامی که این فناوری از زیر دست دانشگاهیان و افراد متخصص بیرون آمد و به یک کد قابل استفاده تبدیل شد که نیازی به داشتن درک عمیق از مفاهیم و تکنیک های هوش مصنوعی نداشت، بسیاری از افراد دیگر نیز توانستند با آن کار کرده و محتواهای جعلی تولید کنند. طولی نکشید که شخصیتهای سیاسی، بازیگران و دیگر چهرههای مشهور، خیل عظیم ویدیوهای جعلی خود را در یوتیوب و سایر پلتفرمهای ویدیویی دیدند. حتی در خود وب سایت ردیت هم با وجود سختگیریهای اولیه، مواردی از دیپ فیک که حاوی محتوای غیراخلاقی نبودند، به مرور بیشتر و بیشتر شدند.

روش کار دیپ فیک چگونه است؟

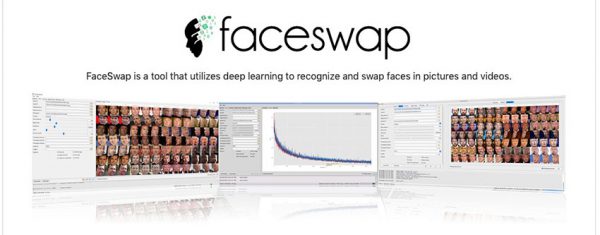

با اینکه استفاده از دیپ فیک چندان هم ساده نیست، اما هر کسی که دانشی متوسط در رابطه با رایانه داشته باشد، میتواند آن را به کار بگیرد. در ابتدا، استفاده از فناوری دیپ فیک و خلق محتوای جعلی احتیاج به منابع و مهارت زیادی داشت که فقط در اختیار تعداد معدودی از متخصصان بودند، اما در حال حاضر ابزارهای متعددی برای این منظور طراحی شده که به واسطه آنها، همه میتوانند به راحتی و با استفاده از تجهیزات رایانهای معمولی، اقدام به ساخت دیپ فیک کند.

اگر چه ساخت دیپ فیک با استفاده از منابع دلخواه میتواند قدری سخت باشد، اما حداقل، به سادگی میتوان از لینکهای یوتیوب برای این کار استفاده کرد. در واقع، امروزه ابزارهای خودکاری طراحی شدهاند که تنها کافیست لینک چند ویدیوی یوتیوب چند دقیقهای که شامل چهره فرد هدف میباشد را به آنها بدهید، تا فریمهای حاوی چهره را استخراج کرده و در محتوای اصلی جایگزین کنند.

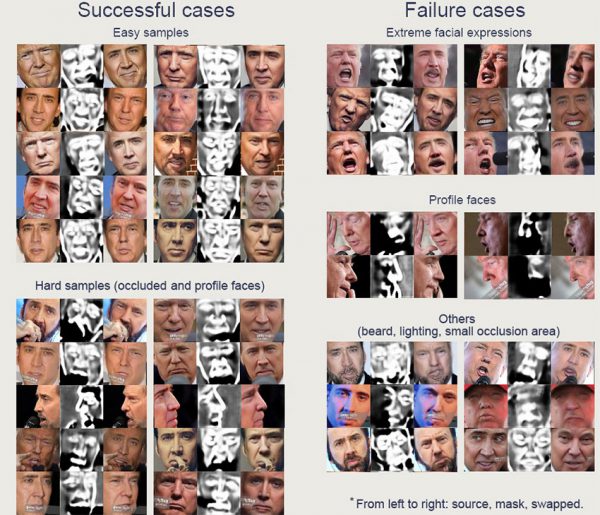

اینگونه نرم افزارها ابتدا ویژگیهای مختلف ویدیوی اصلی مانند رنگ پوست، حالت صورت، زاویه سر و میزان چرخش آن، و روشنایی محیط را بررسی میکند و سپس سعی می کند تا تصویر را با چهره فرد جایگزین و با چنین ویژگیهایی بازسازی کند. نسخه های اولیه این نرم افزار به روزها یا حتی هفتهها زمان نیاز داشتند تا همه این جزئیات را بررسی و اعمال کنند، اما در نمونههای جدیدتر، تنها با استفاده از یک کارت گرافیک انویدیا GTX 1018 TI، در عرض 72 ساعت میتوان به نتیجه رسید و یک ویدیوی جعلی واقعگرایانه خلق کرد.

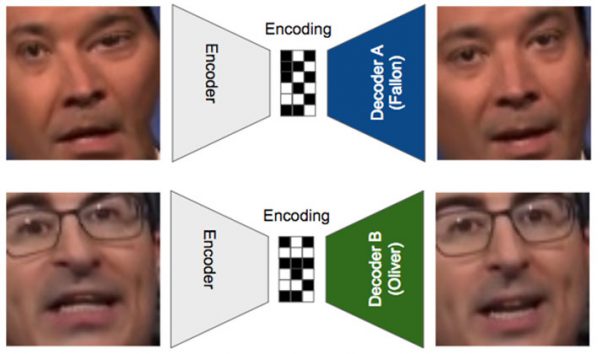

اگرچه تکنیکهایی هم که از روشهای نه چندان پیچیدهتری برای جعل محتوا استفاده میکنند، می توانند به همان اندازه ویرانگر و مخرب باشند، اما در نمونههای واقعی و دقیق دیپ فیک از روشی به نام «شبکههای مولد متخاصم» (GAN) استفاده میشود. این روش در حقیقت شامل دو الگوریتم یادگیری ماشین است که در یکی از آنها هدف تولید تصویر است و دیگری برای شناسایی آن تلاش میکند. این دو الگوریتم به صورت دو رقیب آنقدر به رقابت با هم ادامه میدهند تا در نهایت الگوریتم تولید تصویر پیروز شود!

در واقع، روش کار به این صورت است که ابتدا الگوریتم مربوط به هوش مصنوعی اول، اقدام به تولید تصویر میکند، سپس الگوریتم دوم آن را بررسی میکند و اگر بتواند همچنان آن را به عنوان تصویر شخصیت اصلی شناسایی کند، روند دوباره تکرار خواهد شد و هوش مصنوعی اول تلاش خواهد کرد تا تصویر را بهبود دهد. در همین حین، الگوریتم دوم هم تلاش میکند تا از دادههای مراحل قبلی استفاده کرده و قدرت تشخیص خود را افزایش دهد. این روند تا جایی ادامه پیدا میکند که تصویر تولید شده توسط هوش مصنوعی اول بتواند الگوریتم دوم را فریب دهد و یا شخص تولید کننده محتوا به این نتیجه برسد که حاصل کار قابل قبول بوده و نیازی به ادامه کار نیست.

شایان ذکر است که دسترسی به GAN ها دیگر محدود به افرادی با بودجه کلان و مجهز به ابر رایانهها، نیست و بدون نیاز به امکانات خاص هم میتوان از آن استفاده کرد که همین مسئله باعث گسترش روزافزون محتواهای جعلی شده است.

دیپ فیک چه تأثیری بر امنیت سایبری دارد؟

با اینکه دیپ فیک در چند وقت اخیر سر و صدای زیادی به راه انداخته، اما این فناوری در واقع ادامه دهنده یک بازی قدیمی، به نام دستکاری محتوای رسانهای است. دستکاری تصاویر و ویدیوها از زمانهای قدیم و با شیوههای سادهای مانند تدوین و ادغام کردن نوارهای صوتی و تصویری وجود داشته و تا استفاده از فتوشاپ و سایر ابزارهای ویرایشی مدرن، پیش رفته است. اما اکنون GAN ها روش جدیدی برای بازی با محتوای رسانهای و دستکاری آنها، ارائه کردهاند. با این وجود، به نظر نمیرسد دیپ فیک بتواند تهدیدی جدی برای بازیگران و سلبریتیها باشد، همان طور که فتوشاپ هم با وجود قابلیتهای بالایی که دارد، یک تهدید واقعی و معضل تمام عیار محسوب نمیشود. بنابراین، شاید بتوان گفت برخی اظهارنظرهایی که در چند وقت اخیر در مورد تأثیرات دیپ فیک شده و تهدیدات ناشی از آن را با روش کلاهبرداری فیشینگ (کلاهبرداری از طریق جعل محتوایی مانند یک سایت) مقایسه کردهاند، تاحدودی اغراق آمیز به نظر میرسد.

البته دیپ فیک به واسطه اینکه میتواند اتفاقات را به شکل دیگری نمایش دهد، پتانسیل بالایی برای جلب توجه دارد. با توجه به همین مسئله نیز مطمئناً ممکن است هکرها بتوانند از دیپ فیک به شیوهای مشابه با سایر محتوای فیشینگ استفاده کرده و با فریب دادن افراد، آنها را به کلیک کردن روی لینک یک بدافزار و یا ارائه اطلاعات، ترغیب کنند و یا اینکه در حین تماشای ویدیو، آنها را به صورت مخفیانه به وب سایتهای حاوی بدافزار هدایت کنند. اما همان طور که قبلاً هم اشاره کردیم، برای رسیدن به چنین اهدافی نیازی به استفاده از تکنیکهایی به پیچیدگی دیپ فیک نیست.

چیزی که در مورد مجرمان میدانیم، این است که آنها علاقهای به صرف وقت و تلاش زیاد برای استفاده از روشهای ندارند و ترجیح میدهند از شیوههای سادهتری که به خوبی هم جواب میدهند، استفاده کنند. واقعیت این است که هنوز هم حقههای سادهتر فیشینگ که سالهاست مورد استفاده قرار میگیرند، قربانیان زیادی دارند و در چنین شرایطی به نظر نمیرسد فناوری دیپ فیک بتواند به ابزاری جدی برای این نوع جرایم سایبری تبدیل شود.

با این حال، بهتر است مطلع باشید که تاکنون موارد اندکی از کلاهبرداری صوتی به وسیله دیپ فیک گزارش شده است که در آنها تلاش شده کارمندان شرکتها را نسبت به واریز پول به حسابهای جعلی متقاعد کند. به نظر میرسد اینگونه اقدامات در واقع یک رویکرد جدید در تاکتیک فیشینگ ایمیلی است که در آن کلاهبرداران با استفاده از صدای جعلی یکی از کارمندان ارشد که با فناوری دیپ فیک تولید شده است، دستور پرداخت را به کارمندان دیگر داده و از آنها کلاهبرداری میکنند. چنین مواردی نشان دهنده این واقعیت هستند، که مجرمان همواره تاکتیکهای جدید را به امید رسیدن به پول، آزمایش میکنند و شما هرگز نمیتوانید آنقدر مراقب باشید که به هیچ وجه در دام آنها نیفتید.

شاید بتوان گفت اصلیترین نگرانی در مورد دیپ فیک، استفاده از محتوای جعلی تولید شده با این فناوری، جهت توهین به اشخاص، تلاش برای بی اعتبار کردن افراد، چه در محیط کار و چه در زندگی شخصی، و استفاده گسترده از آن در فیلمهای مستهجن باشد. امکان استفاده از دیپ فیک برای بی اعتبار کردن مدیران یا شرکتها توسط رقبا نیز اصلاً دور از ذهن به نظر نمیرسد. اگرچه احتمالاً خطرناکترین تهدید ناشی از این فناوری، میتواند مربوط به جنگ نرم و ارائه اطلاعات نادرست در زمانهای حساسی مانند انتخابات باشد.

چگونه میتوان محتوای دیپ فیک را تشخیص داد؟

بسته به میزان پیچیدگی GAN های استفاده شده و کیفیت تصویر نهایی، ممکن است بتوان نقصهایی را در دیپ فیک مشاهده کرد؛ به همان شیوهای که اغلب با بازبینی دقیق تصاویر فوتوشاپی، میتوان به وجود تضادهایی در کنتراست، نورپردازی عجیب و غریب و یا مواردی از این دست پی برد. با این حال، شبکههای مولد متخاصم یا GAN ها توانایی تولید تصاویری با کیفیت بسیار بالا را دارند که شاید تنها شبکه دیگری از همین نوع، توانایی تشخیص جعلی بودن آنها را داشته باشد. البته از آنجا که ایده اصلی استفاده از GANها این است که در نهایت تصویر تولید شده بتواند از فیلتر تشخیصی این هوش مصنوعی عبور کند، ممکن است استفاده از خود این شبکهها برای تشخیص جعلی بودن یک محتوا، همیشه موفقیت آمیز نباشد.

با این حال، بهترین قاضی برای تشخیص محتوای جعلی، در واقع توانایی ما در درک حقایق است. اگر یک رویداد و یا اثر هنری مانند محتوای صوتی و تصویری را به صورت مستقل و جدا از حقایق دیگر بخواهیم در نظر بگیریم، تشخیص واقعی بودن آن سخت خواهد بود. اما برای داشتن یک تشخیص درست، باید موضوع مورد مطالعه را با توجه به سایر مدارک و شواهد، ارزیابی و قضاوت کنیم. برای روشنتر شدن مطلب بهتر است یک مثال ساده بزنیم. آیا صرف دیدن یک فیلم ویدیویی از اسب در حال پرواز، میتواند شما را متقاعد کند که چنین حیوانای واقعاً وجود دارد؟ مطمئناً پاسخ شما منفی است و برای رسیدن به این پاسخ نیازی نیست جزئیات ویدیوی اسب پرنده را بررسی کنید! برای اینکه بخواهیم واقعی بودن اسب پرنده را تأیید کنیم باید برای یک سری سؤالات پاسخ قانع کنندهای داشته باشیم؛ سؤالاتی مانند اینکه، چه کسی شاهد برخاستن اسب از زمین بوده؟ این اسب در کجا فرود آمده؟ این حیوان در حال حاضر کجا است؟

بنابراین، ما باید هنگام مشاهده محتواهای رسانهای مانند ویدیوها دقت کافی داشته باشیم و زود قضاوت نکنیم، به ویژه هنگامی که ادعاهای عجیب و غریبی در آنها مطرح شده باشد یا دور از ذهن به نظر برسند. البته، پرهیز از قضاوت عجولانه و ناصحیح، مسئله تازهای نیست و در موارد متعدد دیگری نیز به آن تأکید شده است. در واقع، این همان ایدهای است که در تأیید هویت چند عاملی به کار میرود، در تحقیقات جنایی یک استاندارد محسوب میشود و زیر بنای روشهای علمی هم بر همین اساس شکل گرفته است.

میتوان گفت آنچه که در رابطه با دیپ فیک کمی متفاوت است، این است که شاید مجبور باشیم در داوری خود درباره محتوای رسانهای که اقدامات و وقایع دور از ذهن یا جنجالی را به تصویر می کشد، سختگیرانهتر عمل کنیم. البته بررسی دقیق موضوع قبل از قضاوت، کاری است که به هر حال ما همواره باید انجام دهیم و شاید ظهور دیپ فیک تلنگری باشد که ما را ترغیب کند، در این زمینه بهتر از گذشته عمل کنیم.

جمعبندی

با وجود ابزارهایی که امروزه برای ایجاد دیپ فیک در دسترس همه است، قابل درک است که نگرانی در مورد احتمال استفاده نابجا و نادرست از این فناوری وجود داشته باشد. اما این مسئله تقریباً در مورد همه نوآوریهای فناوری صادق است؛ همیشه افرادی وجود خواهند داشت که راههایی برای استفاده از یک فناوری جدید به منظور ضربه زدن به دیگران پیدا کنند. با این وجود، فناوری دیپ فیک یک پیشرفت جدید مشابه با سایر ابزارهای یادگیری ماشین است که میتواند به طرق مختلفی مانند شناسایی بدافزارها، بر بهبود کیفیت زندگی انسانها تأثیرگذار باشد.

در حالی که تولید ویدیوهای جعلی به منظور جنگ اطلاعاتی امری ممکن و محتمل میباشد، اما امکان تشخیص جعلی بودن این محتواها، با استناد به اطلاعات دیگری که از درستی آنها اطمینان داریم، همواره وجود خواهد داشت. پس، آیا باید نگران دیپ فیک باشیم؟ در پاسخ باید گفت، بیشتر از اینکه نگران دیپ فیک باشیم، باید نگران زودباور بودن خودمان و پذیرش ادعاهای عجیب و غریبی باشیم که بدون هیچ سند و مدرکی – غالباً در فضای مجازی – ارائه میشوند و هیچگاه به دنبال سنجش اعتبار آنها نیستیم.